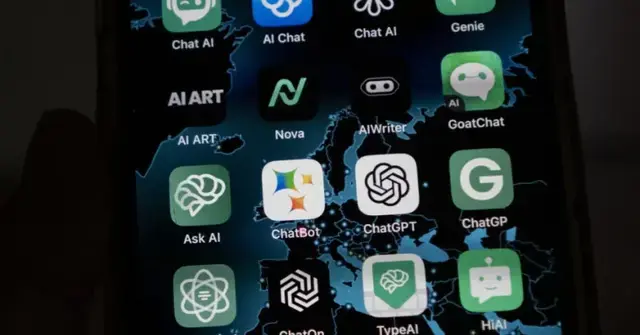

Az AI-modellek világában hatalmas a versengés.

A nagy nyelvi modellek (LLM) világában egyre fokozódó verseny figyelhető meg, amelyet a mesterséges intelligencia gyors ütemű fejlődése generál. Ez a helyzet különösen bonyolulttá válik a vállalati szektorban, ahol a hatékony AI-megoldások felkutatása elengedhetetlen. De mik is a lényeges eltérések a különböző modellek között, és milyen szempontokat érdemes figyelembe venni a választás során?

A nagy nyelvi modellek versenye nem csupán a problémamegoldás terén éri el tetőpontját, hanem a multimodális információfeldolgozás – azaz szöveg, kép és hang integrálása – valamint a költséghatékonyság szempontjából is forradalmi átalakulásokat hoz magával. 2025 elején számos innovatív modell lépett színre, melyek közül az OpenAI, a Google és a DeepSeek által fejlesztettek kiemelkedő technológiai áttöréseket mutatnak.

Az OpenAI legújabb fejlesztése, az o3-mini, jelentős előrelépést képvisel az előző, o1-es modellhez képest. Nem csupán a költséghatékonyság terén mutat kiemelkedő teljesítményt, hanem logikus és áttekinthető gondolkodásmódjával is. Ez a modell 200 ezer tokenes kontextusablakkal bír, amely lehetővé teszi a hosszú távú összefüggések észlelését, a komplex tudományos kutatások alapos elemzését, valamint a versenyképes programozási feladatok hatékony megoldását. Az o3-mini ideális választás olyan kihívásokhoz, ahol a precíz és jól strukturált gondolkodás elengedhetetlen.

A Google legújabb zászlóshajója, a Gemini 2.0, egy teljesen új megközelítést kínál, amely lehetővé teszi akár több könyvnyi információ egyidejű feldolgozását. A modell 1 millió tokenes kontextusablakkal rendelkezik, ami akár 1500 oldalnyi szöveg vagy 30 ezer sornyi kód feldolgozását teszi lehetővé. Emellett képes hangot, képet és videót is kezelni, és zökkenőmentesen integrálódik a Google szolgáltatásaival, mint például a kereső, a térkép vagy a YouTube.

A DeepSeek januárban bemutatott R1 modellje egy nyílt forráskódú megoldás, amely számos területen versenytársaival megegyező szintű teljesítményt nyújt. A modell 128 ezer tokenes kontextusablakkal rendelkezik, és 671 milliárd paramétert foglal magában. A DeepSeek dokumentációja szerint a modell fejlesztési költségei jelentősen alacsonyabbak, mint a hagyományos zárt rendszerek esetében. Kiemelkedő matematikai és adatelemzési képességekkel rendelkezik, bár a nyelvi készségek terén még nem érte el versenytársai szintjét.

A modellek közötti választás során érdemes figyelni a következő paraméterekre: a kontextusablak mérete, a modell képességei a multimodális információfeldolgozás terén, a költséghatékonyság, valamint az adott feladathoz szükséges precízió és strukturáltság. A tesztelés során érdemes olyan feladatokat választani, amelyek közvetlenül kapcsolódnak a vállalat igényeihez, és figyelembe venni a modell integrálhatóságát a meglévő rendszerekbe.